SMP 2019 第三届中文人机对话技术评测顺利落幕

2019年08月20日近年来,人机对话技术受到了学术界和产业界的广泛关注。学术上,人机对话是人机交互最自然的方式之一,其发展影响及推动着语音识别与合成、自然语言理解、对话管理以及自然语言生成等研究的进展;产业上,众多产业界巨头相继推出了人机对话技术相关产品,如个人事务助理、虚拟情感陪护机器人、娱乐型聊天机器人等等,并将人机对话技术作为其公司的重点研发方向。以上极大地推动了人机对话技术在学术界和产业界的发展。

技术评测现场

本届ECDT 由中国中文信息学会社会媒体处理专委会主办,以第八届全国社会媒体处理大会(The Eighth China National Conference on Social Media Processing, SMP)为平台,专委会组织了本届中文人机对话技术评测。评测委员会的人员如下所示:

委员会

主席:张伟男(哈尔滨工业大学)

副主席:陈志刚(科大讯飞)、车万翔(哈尔滨工业大学)、黄民烈(清华大学)、张轶博(华为公司)

评测委员会成员:朱才海(哈尔滨工业大学)、覃立波(哈尔滨工业大学)、郑银河(清华大学)、王栋(科大讯飞)

张伟男副教授发表讲话

本次评测包含两个评测任务,即任务一:自然语言理解评测,任务二:个性化对话竞赛。截止到评测结束,共有136 支队伍报名参与竞赛,其中任务一报名队伍数量为125 支,共有30 支队伍提交评测。任务二报名队伍数量为53 支,共有8 支队伍提交评测。评测报告下载链接请查看文章结尾处附录。

本次评测奖金由华为公司提供,具体的奖金分配如下:

任务1:第一名 12000 元, 第二名 8000 元, 第三名 5000 元。

任务2:第一名 12000 元, 第二名 8000 元, 第三名 5000 元。

颁奖仪式合影

任务一针对自然语言理解模块,其主要包括下面三个子任务:领域分类、意图识别和语义槽填充。与去年评测中只进行领域分类不同,本次任务一同时进行三项任务的评测,以更好的评测各个参赛系统的自然语言理解能力。

在评价方式上,对于领域分类和意图识别:采取准确率(acc)来进行评价。对于语义槽填充:采用了F 值评价。

为了综合考虑模型的能力,任务一最终采用句准确率(sentence acc)来衡量一句话领域分类、意图识别和语义槽填充的综合能力,即以上三项结果全部正确时候才算正确,其余均算错误。

任务一的最终评测结果如下所示:

任务一的最终评测结果

任务二针对个性化对话的生成,期望参赛者在生成的回复中体现特定的性别,地域和爱好特征。如果能够有效地解决这一任务可以极大地提升人机对话系统的智能化程度,从而带来更好的用户体验。

在评价方式上,任务二的初赛阶段采用自动评价的方式,评价指标主要为BLEU、Perplexity 和Distinct。

同时,为了更好地评价参赛者生成的结果的实际交互体验。在决赛阶段,采用了人工评价的方式进行评测,主要使用了以下三个指标:

• Fluency:生成回复的表达是否流畅,无语法错误。

• Personality:生成回复是否符合所给定的发话人个性化特征。

• Appropriateness:生成回复是否符合人们的日常交流习惯。

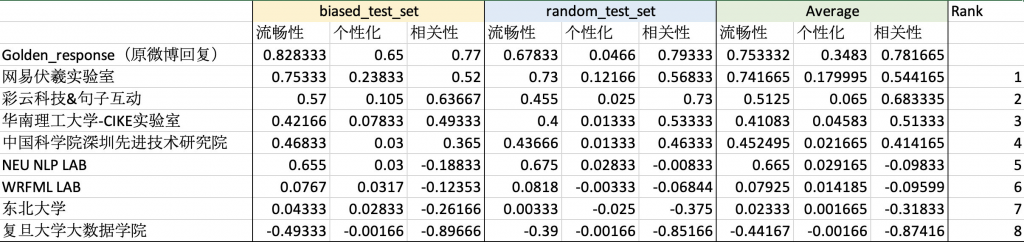

最终的自动评价与人工评价的结果如下所示:

任务二自动评测结果:

任务二自动评测结果

任务二人工评测结果:

任务二人工评测结果

本次评测经过近五个月的筹备和角逐,目前已顺利落下帷幕,在此感谢中国中文信息学会社会媒体处理专委会及第八届全国社会媒体处理大会对本次评测的支持,感谢所有参赛单位的积极参与,同时感谢科大讯飞股份有限公司提供的评测数据及人工评价支持和华为公司提供的奖金支持,也期望中文人机对话评测能够促进人机对话技术的交流、推动人机对话技术的进步与落地。

附录

评测报告下载链接:

https://pan.baidu.com/s/1UpI6EjmLrSGjICUmCGtJrA