第63届计算语言学协会年会 (Annual Meeting of the Association for Computational Linguistics, ACL 2025)于 2025 年 7 月 27 日至 8 月 1 日 在奥地利维也纳举行,实验室教师车万翔教授受邀担任 ACL 2025 Program Chair(程序委员会主席),实验室二十余名师生参会。

ACL年会是计算语言学和自然语言处理领域最重要的顶级国际会议,CCF A类会议,由计算语言学协会主办,每年举办一次,2025年是第63届会议,ACL 2025会议共接收了1700余篇主会论文,哈尔滨工业大学社会计算与交互机器人研究中心有20篇长文被ACL 2025主会录用,9篇长文被Findings of ACL录用,1篇文章被ACL Demo Track录用。

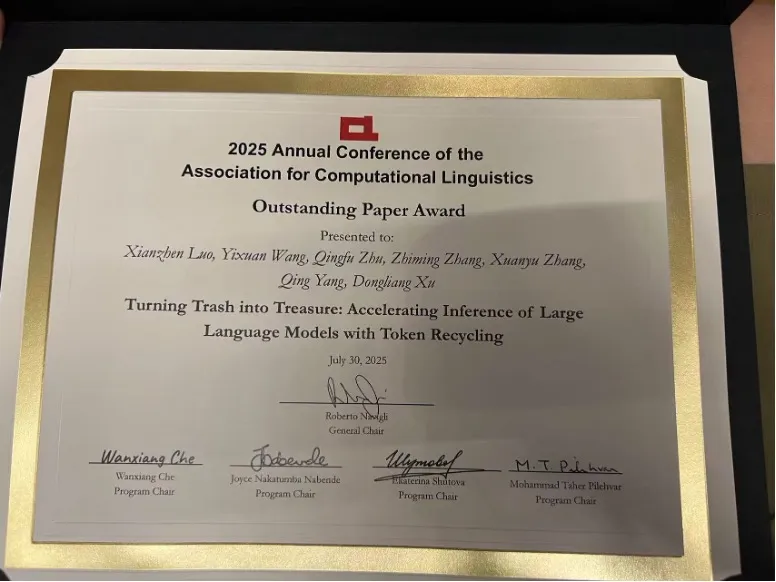

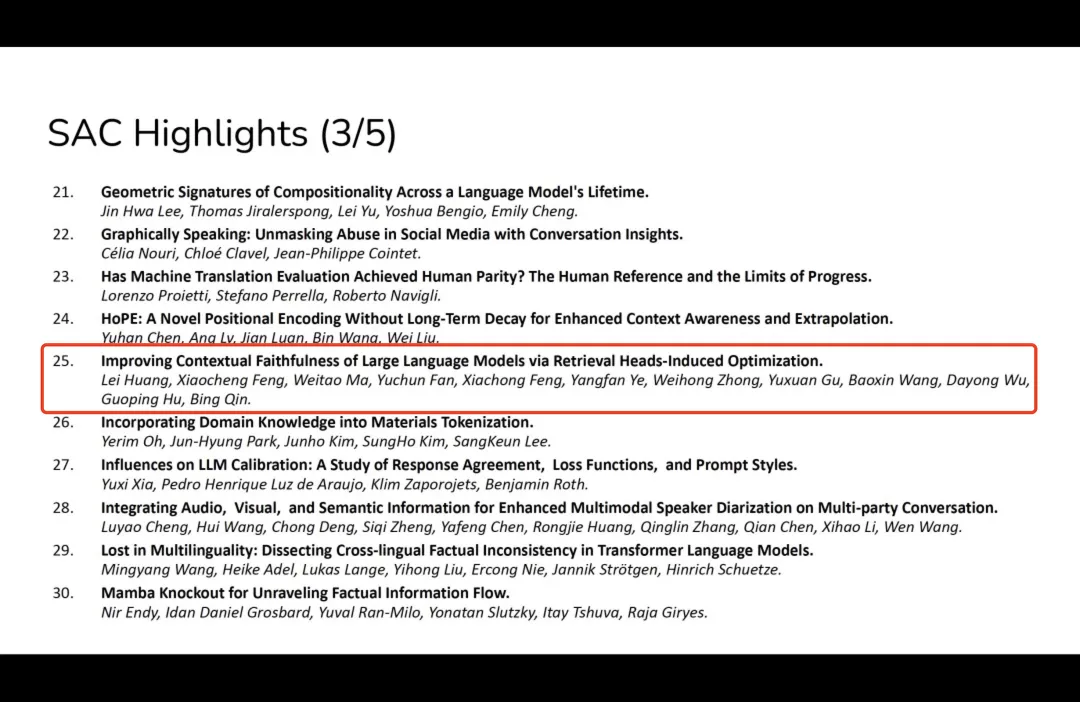

实验室博士生罗先镇获得ACL 2025 杰出论文奖(Outstanding Paper),博士生黄磊获得ACL 2025 SAC Highlight paper奖,博士生赵伟翔的论文入选Oral & Panel Discussion(仅有25篇)。

ACL 2025 Outstanding Paper Award(杰出论文奖)

ACL 2025 SAC Highlight paper奖

博士生赵伟翔 Oral & Panel Discussion现场

以下是两篇获奖论文的介绍:

题目:Turning Trash into Treasure: Accelerating Inference of LargeLanguage Models with Token Recycling

作者:罗先镇,王一轩,朱庆福,张致铭,张玄昱,杨青,许冬亮

类型:ACL 2025, Long Paper

大型语言模型参数数量的迅猛增长,使得推理延迟成为一个关键瓶颈。投机解码利用猜测并验证的范式来无损加速推理。一些投机解码方法依赖额外架构来生成草稿token,这类方法在使用前需要额外训练;而基于检索的免训练方法则通过预存语料库或n-gram生成来构建候选库,但这类方法存在存储需求大、检索耗时和适应性差的问题。我们观察到,在解码过程中生成的候选token往往会在后续序列中再次出现,基于此提出了Token Recycling。该方法将候选token存储在邻接矩阵中,并使用类似广度优先搜索(BFS)的算法构建草稿树,随后通过树注意力机制进行验证。新生成的候选token也会用于更新邻接矩阵。Token Recycling仅需不到2MB的额外存储,在各类LLMs中实现了约2倍的推理加速,性能相比现有免训练方法提升约30%,甚至超过了一种需要训练方法25%的表现。

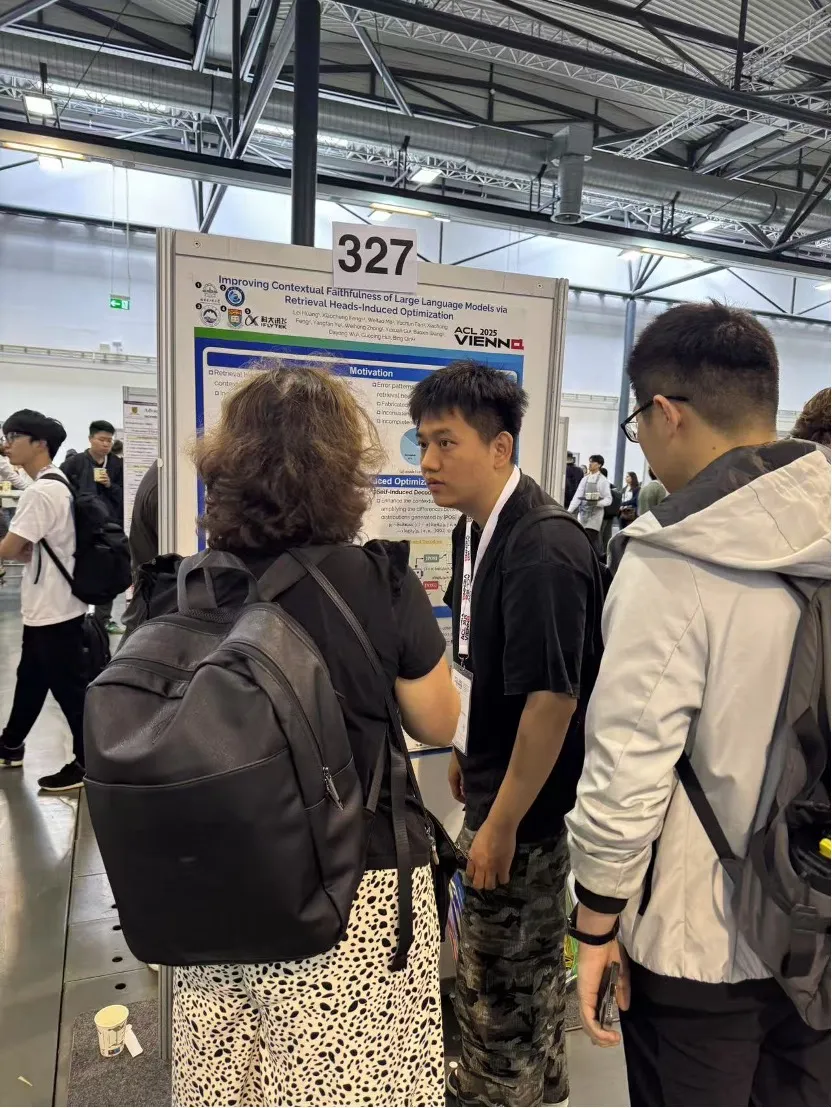

题目:Improving Contextual Faithfulness of Large Language Models via Retrieval Heads-Induced Optimization

作者:黄磊,冯骁骋,马伟涛,范瑀纯,冯夏冲,叶扬帆,钟蔚弘,顾宇轩,王宝鑫,伍大勇,胡国平,秦兵

类型:ACL 2025, Long Paper

在检索增强大语言模型中,确保上下文忠实性对于构建值得信赖的信息检索系统至关重要,尤其是在复杂的长篇问答场景中。在这本研究中,我们发现大模型的上下文忠实程度与检索头(retrieval heads)之间存在显著相关性,这些检索头是一组专门负责检索上下文信息的注意力头。基于这一发现,我们提出了RHIO框架,旨在训练大模型显式区分忠实与不忠实的内容,从而增强上下文忠实性。RHIO首先通过选择性屏蔽检索头来生成不忠实样本,这些样本能有效模拟模型在实际应用中可能出现的忠实性幻觉。随后,我们将这些样本纳入联合训练过程,使模型能够在特定的控制标记引导下激活不同的检索注意力模式。此外,这些控制标记结合对比解码能够放大忠实和不忠实输出之间的概率分布差异,进一步提升模型忠实性。为评估上下文忠实性,我们构建了GroundBench,这是一个由五个现有的长篇问答数据集整合而成的综合基准测试集。在GroundBench上的广泛实验结果表明,RHIO显著提高了模型的忠实度表现,甚至超越了GPT-4o。

车万翔教授受邀担任ACL 2025 程序委员会主席

SCIR参会师生合影

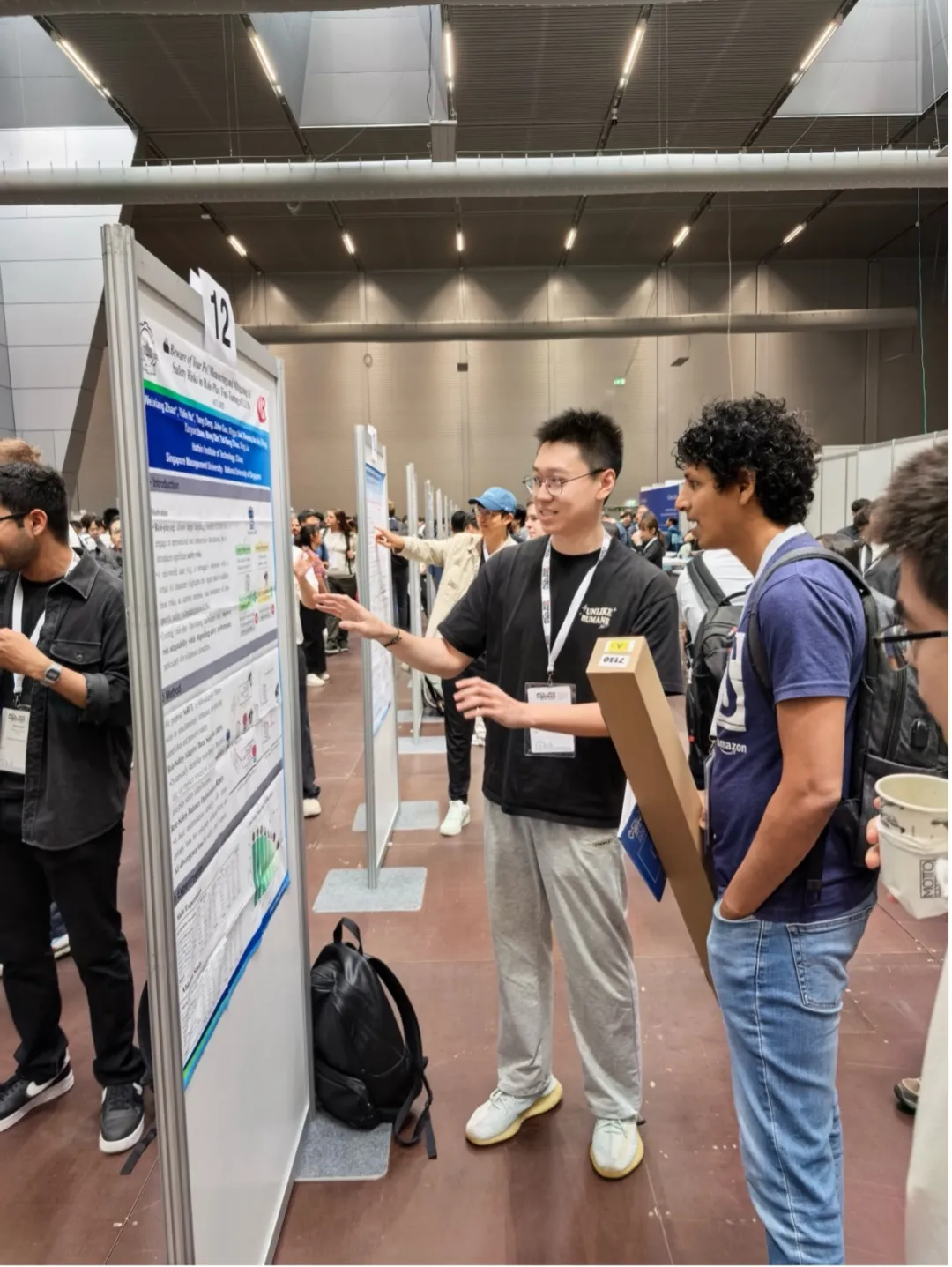

ACL 2025会议现场